Эксперты, в том числе руководители OpenAI и Google Deepmind, предупреждают, что искусственный интеллект может привести к вымиранию человечества.

Десятки поддержали заявление, опубликованное на веб-странице Центра безопасности ИИ.

«Снижение риска исчезновения из-за ИИ должно быть глобальным приоритетом наряду с другими рисками социального масштаба, такими как пандемии и ядерная война», — говорится в нем.

Но другие говорят, что опасения преувеличены.

Сэм Альтман, исполнительный директор компании OpenAI, создавшей ChatGPT, Демис Хассабис, исполнительный директор Google DeepMind и Дарио Амодеи из Anthropic поддержали это заявление.

Сайт Центра безопасности ИИ предлагает ряд возможных сценариев катастрофы:

- ИИ можно превратить в оружие — например, инструменты для обнаружения наркотиков можно использовать для создания химического оружия.

- Дезинформация, генерируемая искусственным интеллектом, может дестабилизировать общество и «подорвать коллективный процесс принятия решений».

- Сила ИИ может все больше концентрироваться в руках все меньшего и меньшего числа рук, что позволит «режимам навязывать узкие ценности посредством повсеместного наблюдения и жесткой цензуры».

- Ослабление, при котором люди становятся зависимыми от ИИ, «по аналогии со сценарием, изображенным в фильме «Валл-И».

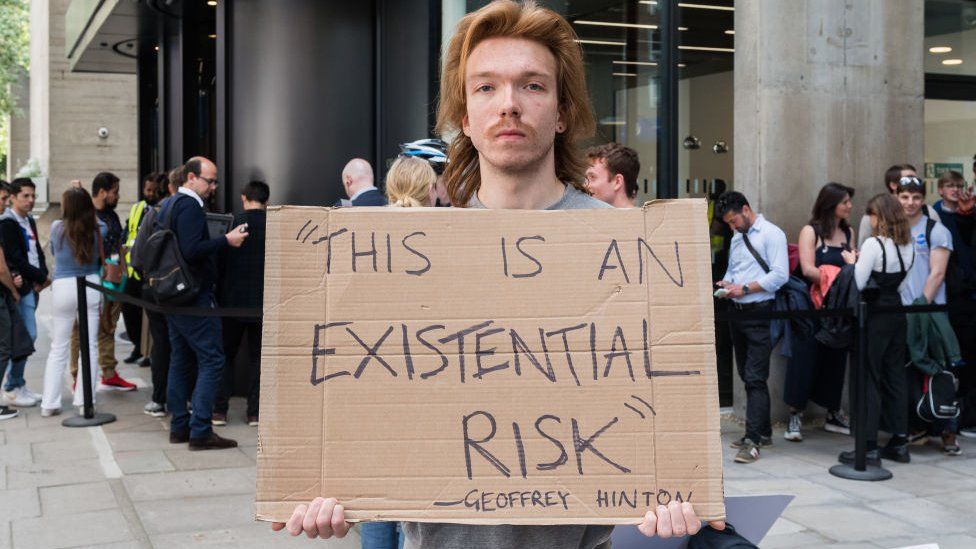

Доктор Джеффри Хинтон, ранее предупредивший о рисках, связанных со сверхинтеллектуальным ИИ, также поддержал призыв Центра безопасности ИИ.

Подписался и Йошуа Бенжио, профессор компьютерных наук Монреальского университета.

Д-ра Хинтона, профессора Бенжио и профессора Нью-Йоркского университета Янна Лекуна часто называют «крестными отцами ИИ» за их новаторскую работу в этой области, за которую они вместе получили премию Тьюринга 2018 года, которая отмечает выдающийся вклад в информатику.

Но профессор ЛеКун, который также работает в Meta, сказал, что эти апокалиптические предупреждения преувеличены, написав в Твиттере, что «самая распространенная реакция исследователей ИИ на эти пророчества гибели — это фейспальмирование».

«Разрушение реальности»

Многие другие эксперты также считают, что опасения по поводу того, что ИИ уничтожит человечество, нереальны, а отвлечение внимания от таких проблем, как систематическая предвзятость, уже является проблемой.

Арвинд Нараянан, ученый-компьютерщик из Принстонского университета, ранее говорил Би-би-си, что сценарии катастроф, подобные научно-фантастическим, нереалистичны: «Существующий ИИ далеко не настолько способен, чтобы эти риски материализовались. краткосрочный хароф А.И.».

Старший научный сотрудник Оксфордского института этики в области искусственного интеллекта Элизабет Реньерис сказала BBC News, что ее больше беспокоят риски ближе к настоящему.

«Достижения в области искусственного интеллекта увеличат масштабы автоматизированного принятия решений, которые являются предвзятыми, дискриминационными, исключающими или иным образом несправедливыми, а также непостижимыми и неоспоримыми», — сказала она. Они «приведут к экспоненциальному увеличению объема и распространению дезинформации, тем самым разрушая реальность и подрывая общественное доверие, а также будут способствовать дальнейшему неравенству, особенно для тех, кто остается по ту сторону цифрового разрыва».

По словам Реньерис, многие инструменты ИИ, по сути, «бесплатно пользуются» «всем человеческим опытом на сегодняшний день». Многие обучаются на созданном людьми контенте, тексте, искусстве и музыке, которые они затем могут имитировать, и их создатели «эффективно передали огромное богатство и власть из общественной сферы небольшой горстке частных лиц».

Но директор Центра безопасности ИИ Дэн Хендрикс сказал BBC News, что будущие риски и нынешние проблемы «не следует рассматривать враждебно».

«Решение некоторых проблем сегодня может быть полезно для устранения многих рисков, которые могут возникнуть завтра», — сказал он.

Усилия сверхразума

Освещение в СМИ предполагаемой «экзистенциальной» угрозы со стороны ИИ резко возросло с марта 2023 года, когда эксперты, в том числе глава Tesla Илон Маск, подписали открытое письмо, призывающее остановить разработку технологии ИИ следующего поколения.

В этом письме спрашивалось, должны ли мы «развить нечеловеческие умы, которые в конечном итоге могут превзойти нас численностью, перехитрить, устареть и заменить нас».

Напротив, новая кампания имеет очень короткое заявление, призванное «открыть дискуссию».

В заявлении риск сравнивается с ядерной войной. В сообщении в блоге OpenAI недавно предположили, что сверхразум может регулироваться аналогично ядерной энергии: «Нам, вероятно, в конечном итоге понадобится что-то вроде МАГАТЭ [Международного агентства по атомной энергии] для усилий в области сверхразума», — написала фирма.

«Будь уверен»

И Сэм Альтман, и исполнительный директор Google Сундар Пичаи входят в число технологических лидеров, которые недавно обсуждали регулирование ИИ с премьер-министром.

Говоря с журналистами о последнем предупреждении о риске ИИ, Риши Сунак подчеркнул преимущества для экономики и общества.

«Вы видели, что в последнее время он помогает парализованным людям ходить, открывает новые антибиотики, но мы должны убедиться, что это делается безопасным и надежным образом», — сказал он.

«Именно поэтому на прошлой неделе я встретился с руководителями крупных компаний, занимающихся искусственным интеллектом, чтобы обсудить, какие барьеры нам необходимо установить, какое регулирование следует ввести, чтобы обеспечить нашу безопасность.

«Люди будут обеспокоены сообщениями о том, что ИИ представляет экзистенциальные риски, такие как пандемии или ядерные войны.

«Я хочу, чтобы они были уверены, что правительство очень внимательно следит за этим».

Сунак сказал, что недавно он обсуждал этот вопрос с другими лидерами на саммите ведущих промышленно развитых стран G7 и вскоре снова поднимет его в США.

G7 недавно создала рабочую группу по ИИ.

Какие у вас есть вопросы об искусственном интеллекте?