Хотя в заголовке написано Deep Mimic «Виртуальный каскадер», довольно сложно точно определить, каков сценарий использования этого исследования. Очевидно, что оно имеет эффект. Посмотрите видео и узнайте, что вы думаете.

Это исследование, проведенное Сюэ Бин Пэн, Питером Аббелем, Сергеем Левиным из Калифорнийского университета в Беркли и Михиэлем ван де Панне из Университета Британской Колумбии, характеризуется по-разному, и это потому, что у этой методики много потенциальных применений, но ни одно из них не выделяется как самое важное. Можно сказать, что речь идет о создании лучшей мультипликационной анимации без помощи человека-аниматора. Это может быть способ заставить виртуальных актеров делать то, что реальным актерам было бы трудно или опасно. Это может быть подход к проблеме локомоции роботов. Возможно, со временем это будет все вышеперечисленное и многое другое.

Так что же такое Deep Mimic?

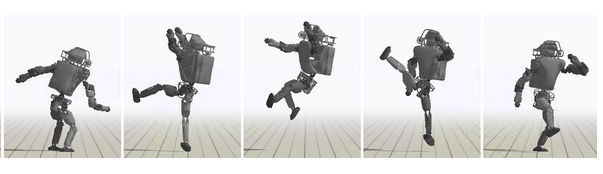

Проще говоря, это нейронная сеть, обученная с помощью обучения с подкреплением для воспроизведения движений с помощью симулированного гуманоида или другого агента. Идея может показаться сложной, и для ее реализации нужно проделать много работы, но на самом деле основная идея достаточно проста. Создайте симуляцию того, что вы хотите анимировать — в видео есть много примеров. Сделайте захват движения человека, делающего то, что вы хотите имитировать. Используйте данные захвата движения для обучения нейронной сети с помощью обучения с подкреплением. Вознаграждение — это просто то, насколько близко симуляция соответствует данным захвата движения. Входные данные — это конфигурация рук и ног в каждый момент времени, а награда — это просто разница между реальным поведением и имитацией в каждый момент времени.

Обучение с подкреплением не дает никакой обратной связи о том, что симуляция делает неправильно, оно просто дает сигнал о том, насколько агент достигает цели, и предоставляет ему самому решать, как улучшить ситуацию.

В данном случае вознаграждение удивительно простое, и кажется, что оно недостаточно тонкое, чтобы направить обучение к правильному решению. Я полагаю, что физика накладывает достаточные ограничения, означающие, что приближение к набору точек на траектории обычно означает приближение к более позднему участку траектории. Даже в этом случае, начиная с холодного, т.е. первого положения, потребуется много проб и ошибок, чтобы добраться до конечного положения. Умный прием, о котором стоит помнить в других ситуациях, заключается в том, что симуляция была запущена в разных точках траектории в попытке завершить действие. Похоже, что это сработало хорошо, и это подкрепляет идею о том, что после запуска физики она ограничивает возможности в достаточной степени, чтобы обучающийся с подкреплением мог совершенствоваться.

Посмотрите видео:

Вы заметите, что некоторые анимации были сделаны для воображаемых существ, таких как Ти-Рекс. Как получить данные захвата движения для них? Ответ: никак. Вы просите художника-аниматора нарисовать несколько ключевых кадров и используете их для обучения. Опять же, это говорит о том, что физика ограничивает задачи так, что между ключевыми кадрами мало решений.

Существует множество способов использования Deep Mimic и множество способов расширить идею. Исследователи пробовали комбинировать действия, расширять действия, помещая их в другую местность, возмущать их, бросая блоки и так далее. Вы можете узнать больше, прочитав доклад, который будет представлен на SIGGRAPH в этом году в августе.

Так для чего же мы можем его использовать?

Вы можете использовать его для создания мультипликационных фильмов по запросу, но, учитывая, что в одной из анимаций был показан робот Boston Dynamics Atlas, я не вижу причин, почему обучение не может быть перенесено на реальную машину. Мы уже видели, как Atlas делал сальто назад, и ему явно требовалась дополнительная практика.

Кроме того, те же анимации не обязательно применять к очевидным мультяшным рендерам. Почему бы не симулировать человекоподобных актеров. Что еще?