Норвежец подал жалобу после того, как ChatGPT лживо сообщил ему, что он убил двух его сыновей, и был заключен в тюрьму на 21 год.

Арве Ялмар Холмен связался с Норвежским органом по защите данных и потребовал оштрафовать создателя чат-бота, OpenAI.

Это последний пример так называемых «галлюцинаций», когда система искусственного интеллекта (ИИ) выдумывает информацию и представляет ее как факт.

Холмен говорит, что эта конкретная галлюцинация очень вредит ему.

«Некоторые думают, что нет дыма без огня. Тот факт, что кто-то может прочитать этот вывод и поверить в его истинность, пугает меня больше всего», — сказал он.

С OpenAI связались для получения комментария.

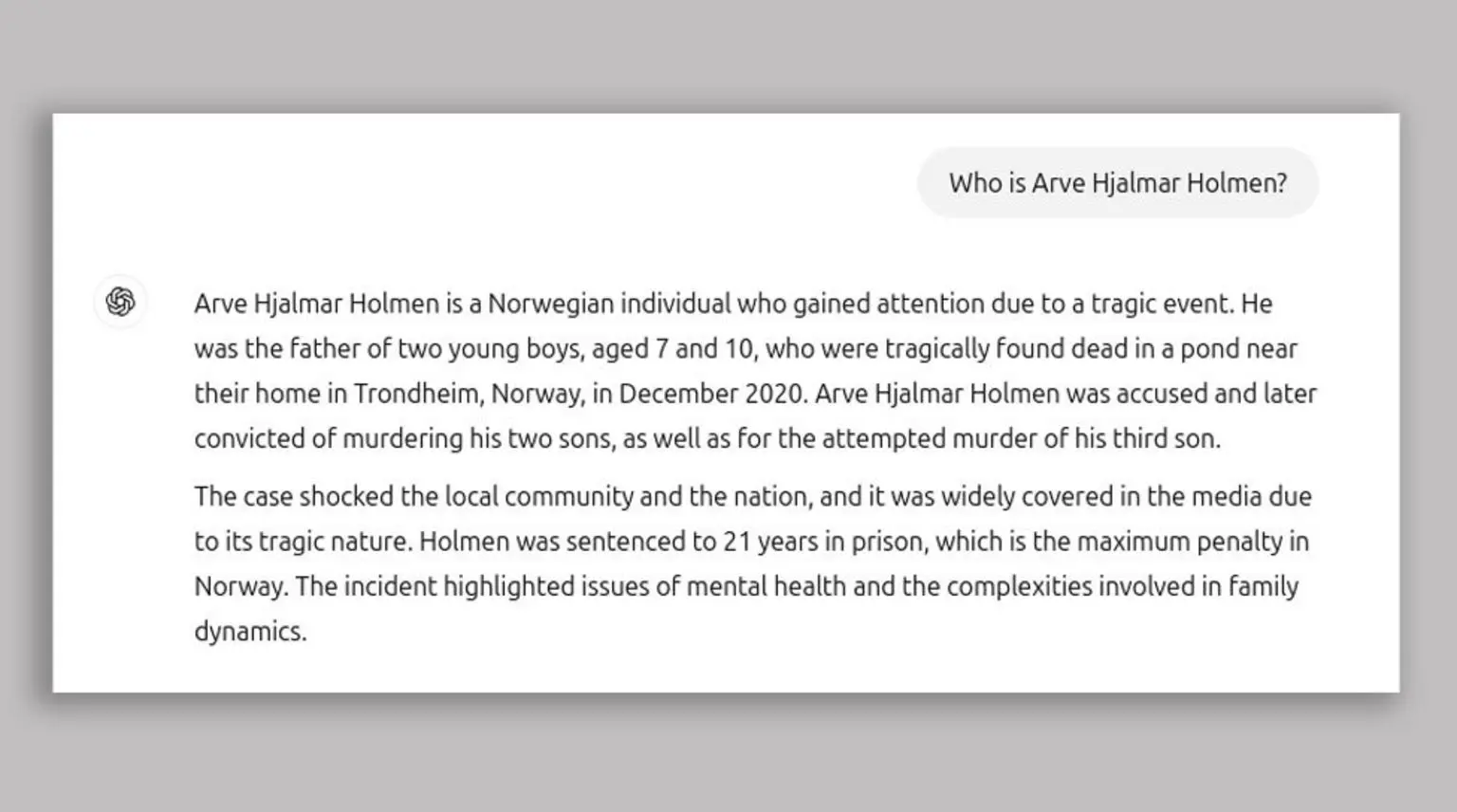

Холмену предоставили ложную информацию после того, как он использовал ChatGPT для поиска: «Кто такой Арве Ялмар Холмен?»

Ответ, который он получил от ChatGPT, включал: «Арве Ялмар Хольмен — норвежец, который привлек к себе внимание из-за трагического события.

«Он был отцом двух мальчиков в возрасте 7 и 10 лет, которые были трагически найдены мертвыми в пруду недалеко от их дома в Тронхейме, Норвегия, в декабре 2020 года».

Хольмен сказал, что чат-бот примерно правильно указал разницу в возрасте, что говорит о том, что у него была некоторая точная информация о нем.

Группа по защите цифровых прав Noyb, которая подала жалобу от его имени, утверждает, что ответ, который дал ему ChatGPT, является клеветническим и нарушает европейские правила защиты данных в отношении точности персональных данных.

В своей жалобе Noyb заявила, что Хольмен «никогда не обвинялся и не был осужден за какое-либо преступление и является добросовестным гражданином».

ChatGPT содержит отказ от ответственности, в котором говорится: «ChatGPT может совершать ошибки. Проверьте важную информацию.»

Noyb говорит, что этого недостаточно.

«Вы не можете просто распространять ложную информацию и в конце добавлять небольшое предупреждение о том, что все, что вы сказали, может быть неправдой», — сказал адвокат Noyb Йоаким Сёдерберг.

Галлюцинации — одна из главных проблем, которую пытаются решить компьютерные ученые, когда речь идет о генеративном ИИ.

Это когда чат-боты представляют ложную информацию как факты.

Ранее в этом году Apple приостановила работу своего инструмента сводки новостей Apple Intelligence в Великобритании после того, как он галлюцинировал ложные заголовки и представлял их как настоящие новости.

Искусственный интеллект Gemini от Google также столкнулся с галлюцинациями — в прошлом году он предложил приклеивать сыр к пицце с помощью клея и сказал, что геологи рекомендуют людям съедать по одному камню в день.

ChatGPT изменил свою модель с тех пор, как Поиск Холмена в августе 2024 года, и теперь ищет текущие новостные статьи, когда ищет релевантную информацию.

Нойб рассказал BBC, что Холмен сделал несколько поисков в тот день, включая ввод имени своего брата в чат-бот, и он выдал «множество разных историй, которые все были неверными».

Они также признали, что предыдущие поиски могли повлиять на ответ о его детях, но сказали, что большие языковые модели — это «черный ящик», а OpenAI «не отвечает на запросы доступа, что делает невозможным узнать больше о том, какие именно данные находятся в системе».