План премьер-министра о том, чтобы Великобритания взяла на себя ведущую роль в регулировании ИИ, окажется под угрозой, если в ноябре не будет принят новый закон, предупредили депутаты.

ЕС может обогнать Великобританию в усилиях по обеспечению безопасности ИИ, если не будут приняты соответствующие меры, заявили министры Комитета по технологиям Commons.

В начале ноября Великобритания проведет международный саммит по искусственному интеллекту.

Правительство сообщило Би-би-си, что готово рассмотреть дальнейшие шаги в случае необходимости.

Но не выяснилось, согласны ли они с тем, что новый закон должен быть предложен так быстро. Вместо этого представитель подчеркнул саммит и первоначальные инвестиции в размере 100 миллионов фунтов стерлингов в рабочую группу, которая будет способствовать безопасной разработке моделей искусственного интеллекта.

Это «больше средств, выделяемых на безопасность ИИ, чем любое другое правительство в мире», заявило правительство Великобритании.

Если законопроект не будет представлен в речи короля 7 ноября, самый ранний законопроект может стать законом в 2025 году, говорится в отчете комитета, опубликованном в четверг.

В докладе утверждается, что отсутствие принятия законодательства в течение двух лет рискует, что Великобритания «останется позади других законов, таких как Закон ЕС об искусственном интеллекте, которые могут стать стандартом де-факто и их будет трудно заменить».

В докладе утверждается, что ситуация может отражать правила защиты данных, в которых законы Великобритании следовали примеру ЕС.

Но хотя в официальном документе правительства по регулированию ИИ признается, что в какой-то момент может потребоваться новый закон, Риши Сунак ранее утверждал, что на начальном этапе «мы, вероятно, сможем сделать многое из этого без законодательства».

Ключевой частью его плана является ноябрьский саммит, который, по словам правительства, станет «первым в мире крупным глобальным саммитом по безопасности ИИ».

Комитет утверждал, что следует пригласить как можно более широкий круг стран, включая Китай.

Имитационная игра

В докладе также выделяются двенадцать «проблем», которые правительство Великобритании должно решить, в том числе:

- Предвзятость: например, инструменты трудоустройства ИИ могут ассоциировать женские имена с традиционно женскими ролями.

- Конфиденциальность: инструменты искусственного интеллекта могут использоваться для идентификации людей спорными способами. Например, полиция использует системы распознавания лиц в реальном времени, которые сканируют лица и сравнивают их со списками подозреваемых.

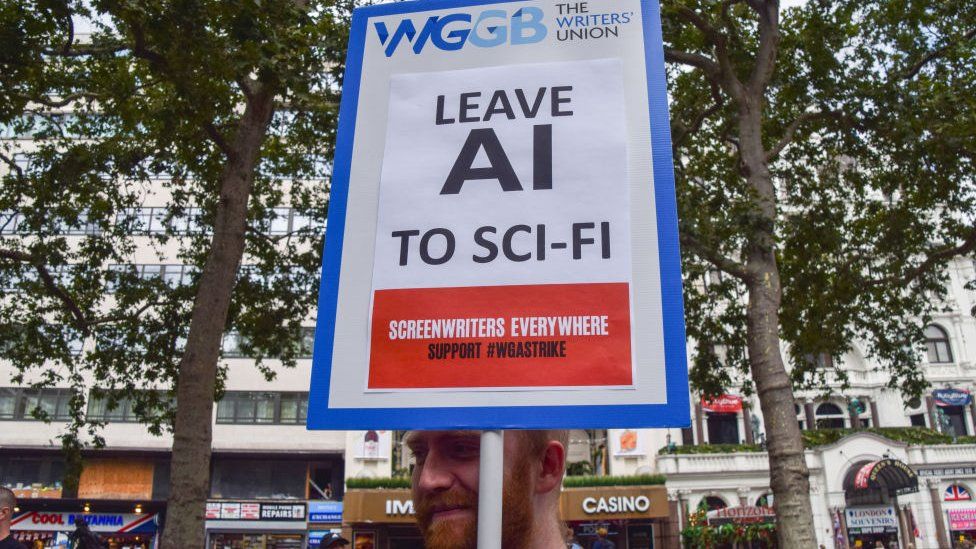

- Занятость: системы искусственного интеллекта заменят некоторые рабочие места, и необходимо будет учитывать экономические последствия этого.

Использование материалов, защищенных авторским правом, для обучения систем искусственного интеллекта также является одной из проблем.

Так называемая генеративная система искусственного интеллекта теперь может создавать новые произведения в стиле известных художников, актеров и музыкантов.

Но чтобы совершить этот подвиг, ИИ обучен на огромном количестве материалов, защищенных авторским правом. Многие авторы, актеры, художники и музыканты утверждают, что ИИ не следует обучать работе с их произведениями без разрешения и компенсации.

В отчете отмечается, что уже предпринимаются шаги по разработке добровольного соглашения, которое позволило бы ИИ получить доступ к произведениям, защищенным авторским правом, и в то же время поддерживать художников.

Запланированное освобождение от авторских прав для искусственного интеллекта было отменено правительством в феврале.

По словам депутатов, способность ИИ подражать людям также может быть использована для распространения дезинформации, мошенничества или обмана банковских систем распознавания голоса.

Нет отказоустойчивости

Отчет последовал за предупреждением, сделанным в среду Национальным центром кибербезопасности, в котором говорится, что большие языковые модели (тип искусственного интеллекта, на котором работают популярные чат-боты) не могут быть защищены от определенных типов атак, призванных убедить их совершать вредоносные действия. В настоящее время не существует «никаких защитных мер», которые могли бы устранить риск, пишет центр.

Депутаты в целом поддержали подход правительства к обеспечению безопасности ИИ, который не требует создания нового регулятора ИИ, а вместо этого передает надзор существующим регуляторам в зависимости от того, чем занимается ИИ.

Некоторые из тех, кто разговаривал с комитетом, в том числе Хью Милвард из Microsoft UK, предпочли этот подход подходу ЕС, который, как он сказал комитету, является «моделью того, как не следует этого делать».

Но ранее он также говорил Би-би-си, что необходимо проявлять осторожность и в отношении любого британского законодательства. Существовала опасность, что один закон попытается сделать все, «а потом он станет чем-то вроде рождественской елки, и каждый попытается повесить на нее свои личные проблемы», сказал он.